Crawl bütçesi, Googlebot’un sitenize belirli bir süre içinde yaptığı istek sayısı daha kaba şekilde taradığı sayfa sayısı-sitede geçirdiği süre diyebiliriz.

Crawl bütçesi optimizasyonu ile Googlebot un önemli içeriklerinizi daha kolay keşfedebilmesini, daha fazla taramasını, harcayacağı zamanı kontrol edebiliriz.

Google belirli zaman aralıklarıyla siteleri tekrar tekrar crawl ediyor.

Gary Illyes, Google’ın crawla başlamadan önce siteye ait URL listesi oluşturduğunu belirtiyor. Ve en olumlu sonucu Googlebot’un tüm sayfaları taraması ile alabiliriz.

Googlebot, tüm listeyi başından sonuna kadar taramaya başlar. Bu listeyi oluşturması için site içinde fazla link çıkışı alan urller, sitemapler gibi alanlar Googlebot’a yardımcı oluyor. Son olarak listeyi taramaya geçtiğinde ise bu listede karşılaştığı 40x,50x hataları, fazla 30x yönlendirmeler gibi negatif durumlarda Googlebot crawl bütçesini düşürür ve daha az sayfa tarayarak siteden ayrılır.

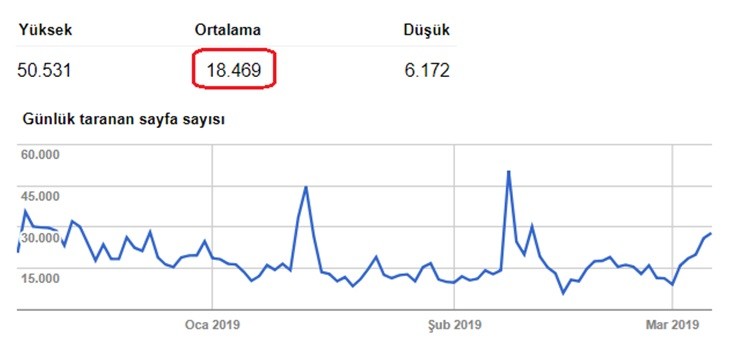

Googlebot’un sitenizde günlük kaç sayfa taradığını, her bir sayfa için ortalama harcadığı zamanı Search console üzerinde bulabilirsiniz. Eski search consoleda Tarama > Tarama İstatistikleri bölümünden bu sayfaya ulaşabiliyoruz.

Crawl bütçesini optimize etmek neden önemlidir?

Googlebot sitemizde hergün belirli sayıda sayfayı tarıyor. Sitemize sınırsız bütçe ayırmadığı için tüm sayfalarımızı tarayamadığı zamanlar durumlar oluyor (genelde böyle zaten). Bütçemiz kısıtlı ise Googlebot’un en önemli sayfaları taramasını sağlamalıyız.

Örneğin “Hakkımızda” sayfasını her sayfadan linkliyorsak, sitemapde ön sıralarda listeliyorsak Googlebot “hakkımızda” sayfasını hergün tarayabilir. Fakat “hakkımızda” sayfası organik trafik hedeflediğimiz sayfa mı? Googlebot’un bu sayfayı taramasına, bütçenin ufakta olsa bir kısmını bu sayfada geçirmesini istiyor muyuz? Hayır.

Crawl bütçesini optimize ederken Googlebot’a, trafiği hedeflediğimiz kaliteli içerik sayfalarını öncelikli taratmayı hedeflemeliyiz.

Crawl bütçesini nasıl optimize edebiliriz?

- Site hızı (her içerikte var yahu)

- Sitemizdeki gereksiz sayfaları temizleme ve indexe kapatma

- Sunucu analizi

Site Hızı Optimizasyonu

Bu başlık altında site hızını nasıl iyileştirebileceğimiz konusuna girmeyeceğim. Pagespeed konusunda çok fazla araç ve içerik var.

Daha önce yaşadığım bir tecrübeyi örnek vermek istiyorum. Müşterimin hergün güncellenmesi gereken içerik sayfaları mevcuttu ve bu sayfa sayısı az değil günde +500 sayfa. Hergün +500 sayfanın Title’ını değiştiğinizi düşünün. Google arama sonuçlarında dünün indexi gözüktüğünde tıklama oranı çok düşük oluyor. Fakat hergün güncel index ile yenilenirse tıklama oranı iki katına çıkıyordu. Bu bizim için çok önemli bir konuydu.

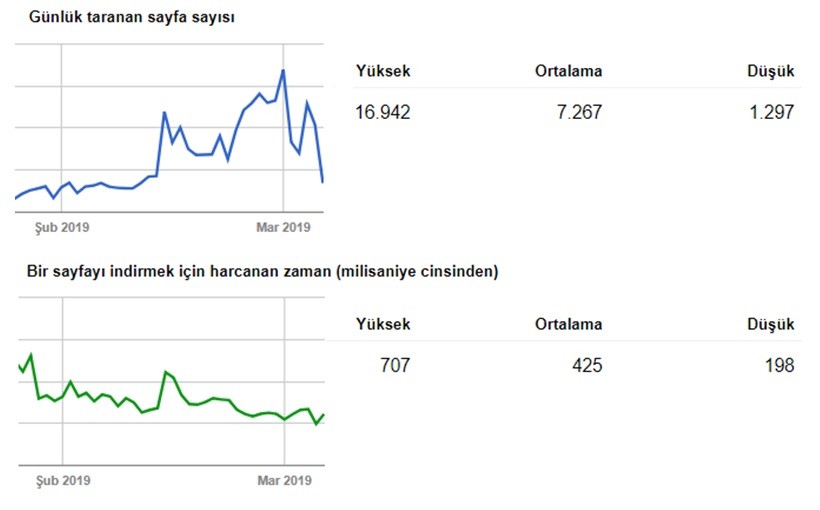

Pagespeed’i nasıl artırırız ve Googlebot’un daha fazla sayfayı taramasını hedefleyelim diyerek çalışmalara başladık. Sayfa yüklenme anında dışarıdan çağrılan, sunucuda bulunan tüm kodları tüm dosyaları inceledik ve optimize ettik. Bu çalışma bize Googlebot’un “bir sayfayı indirmek için harcanan zaman” ının azalmasını kazandırdı.

Aşağıdaki görsele baktığımızda “bir sayfayı indirmek için harcanan zaman” grafiğinin düşüşte olduğunu görüyoruz. “günlük taranan sayfa sayısı” grafiğine baktığımızda alttaki grafikle ters orantılı şekilde yükseldiğini görüyoruz.

Grafiği özetleyecek olursak;

Googlebot’un “sayfa başı harcadığı zaman düşerse taradığı sayfa sayısı artıyor.”

Sitenizdeki Gereksiz Sayfalardan Kurtulun

Özellikle eticaret sitelerinde gereksiz içerik sayfaları, gereksiz parametreler, duplicate algılanacak ürünler gibi birçok gereksiz ve crawl bütçesini kötüye kullanan sayfalar var. Gereksiz sayfaları en aza indirmek için noindex ve canonical etiketlerini kullanmak en sağlıklısı olabilir.

Gereksiz sayfalarınızdan kurtulduğunuzda ve Google indexten kaldırmak istediğinizde tüm bu sayfaları bir dosyada toplayın ve geçici Sitemap oluşturun. Google’a gönderin ve indexlerin kaldırılmasını hızlandırmış olacaksınız. Bunun yanında Robots.txt ile de engelleyebilirsiniz gereksiz sayfaları. Son adım olarak geçici sitemap dosyanızı Search console’dan kaldırabilirsiniz.

Yönlendirmeleri Kontrol Edin

Gereksiz sayfalardan kurtulurken birçok sayfaya yönlendirme eklenebiliyor. Hele ki sitenizin yüz binlerce ürün veya alt sayfası varsa yönlendirilen URL’lerin kontrolü zorlaşabiliyor. Kontrol zorlaştığı için şöyle durumlarla karşılaşabiliyoruz;

A > B sayfasına yönleniyor. 1 ay sonra B > C sayfasına yönleniyor. Bu şekilde yönlendirme sayıları arttıkça birbirini takip eden yönlendirmeler de artıyor.

Bu zincirleme yönlendirmeleri en aza indirmeyi deneyebilirsiniz. Örneğin B > C sayfasına yönlendirildiğinde A sayfasınıda B’ye uğramadan direk C sayfasına yönlendirebilirsiniz.

404 Sayfalarda Canonical Etiketi Kullanmayın

Bu duruma daha çok içerde yazılım geliştiren firmalarda rastlıyoruz. WordPress veya büyük e-ticaret sistemlerinde karşılaşılmıyor bu durumla fakat 404 sayfalarında “canonical” etiketi kullanmak birçok 404 sayfasının indexlenmesine yol açabilir. 404 sayfalarında “canonical” etiketi kullanıyorsanız ve “noindex” etiketi kullanmıyorsanız

gibi gereksiz indexler görebilirsiniz.

Crawl Bütçenizi Analiz Edin

Crawl bütçenizi optimize ettiniz peki nasıl ölçümleyeceğiz?

- Googlebot sayfaya ne sıklıkla geliyor

- En çok hangi sayfayı tarıyor

- X sayfasını tararken ne kadar veri indiriyor

Bu analizi ve ilgili soruları cevaplayabilmek için sunucunun günlük verilerini analiz etmeniz gerekiyor. Excel’de X dosya Y boyut T Sıklık gibi tablolar oluşturarak anlamlandırabilirsiniz fakat önerim Tool kullanmak olacaktır.

Analizi için Splunk, Logentries veya Stackify araçlarını kullanabilirsiniz.

Log analizi kısmı başlı başına bir konu. Sadece bu konu için bir içerik üretilebilir talep olursa eğer üretebilirim.